Premissen för A/B-testning är enkel:

Jämför två (eller fler) olika versioner av något för att se vilken som presterar bäst och distribuera sedan vinnaren till alla användare för den mest optimala helhetsupplevelsen.

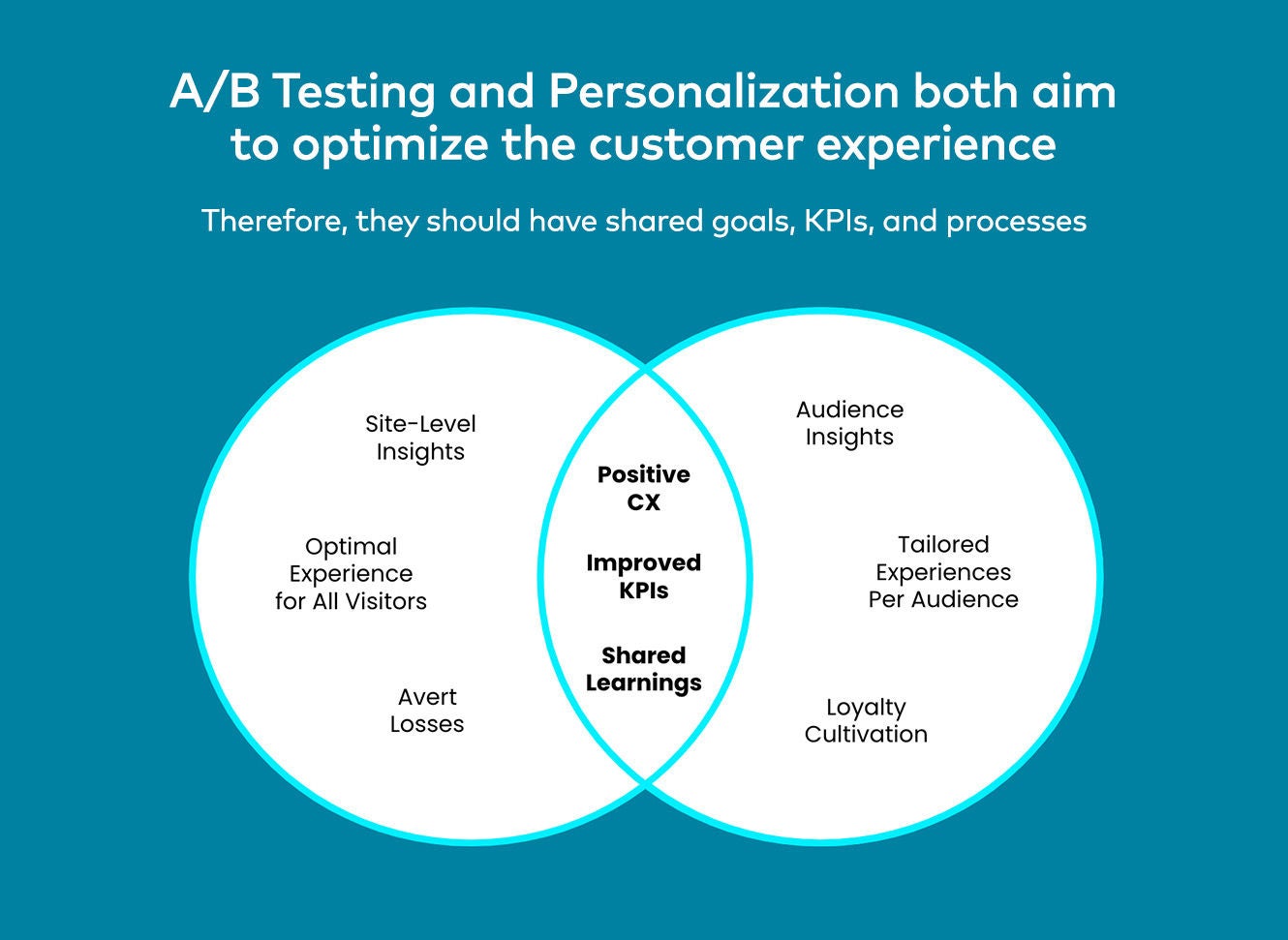

Praxisen för A/B-testnings- och CRO-team har således varit att investera avsevärt i att lansera alla möjliga typer av experiment för att förbättra olika områden och upplevelser på webbplatsen, i native-appen, e-posten eller någon annan digital kanal, och sedan kontinuerligt optimera dem för att driva en stegvis ökning av konverteringar och specifika KPI:er över tid.

Men om inte ett företag genererar massor av trafik och har ett enormt digitalt landskap att experimentera från, kan det komma en punkt med minskande avkastning där resultatet av experiment (oavsett hur många tester eller hur stort och sofistikerat ett experiment än må vara) når maximal avkastning när det gäller input från dessa team.

Detta har till stor del att göra med det faktum att den klassiska metoden för A/B-testning erbjuder en binär bild av besökarnas preferenser och ofta misslyckas med att fånga hela spektrumet av faktorer och beteenden som definierar vilka de är som individer.

Dessutom ger A/B-tester generaliserade resultat baserade på ett segments majoritetspreferenser. Och även om ett varumärke kan uppleva att en viss upplevelse i genomsnitt ger mer intäkter, skulle det vara en otjänst för en betydande del av konsumenterna med olika preferenser att distribuera den till alla användare.

Låt mig illustrera med några exempel:

Om både jag och Warren Buffets nettoförmögenhet i genomsnitt var 117,3 miljarder USD, skulle det vara vettigt att rekommendera samma produkter till oss?

Förmodligen inte.

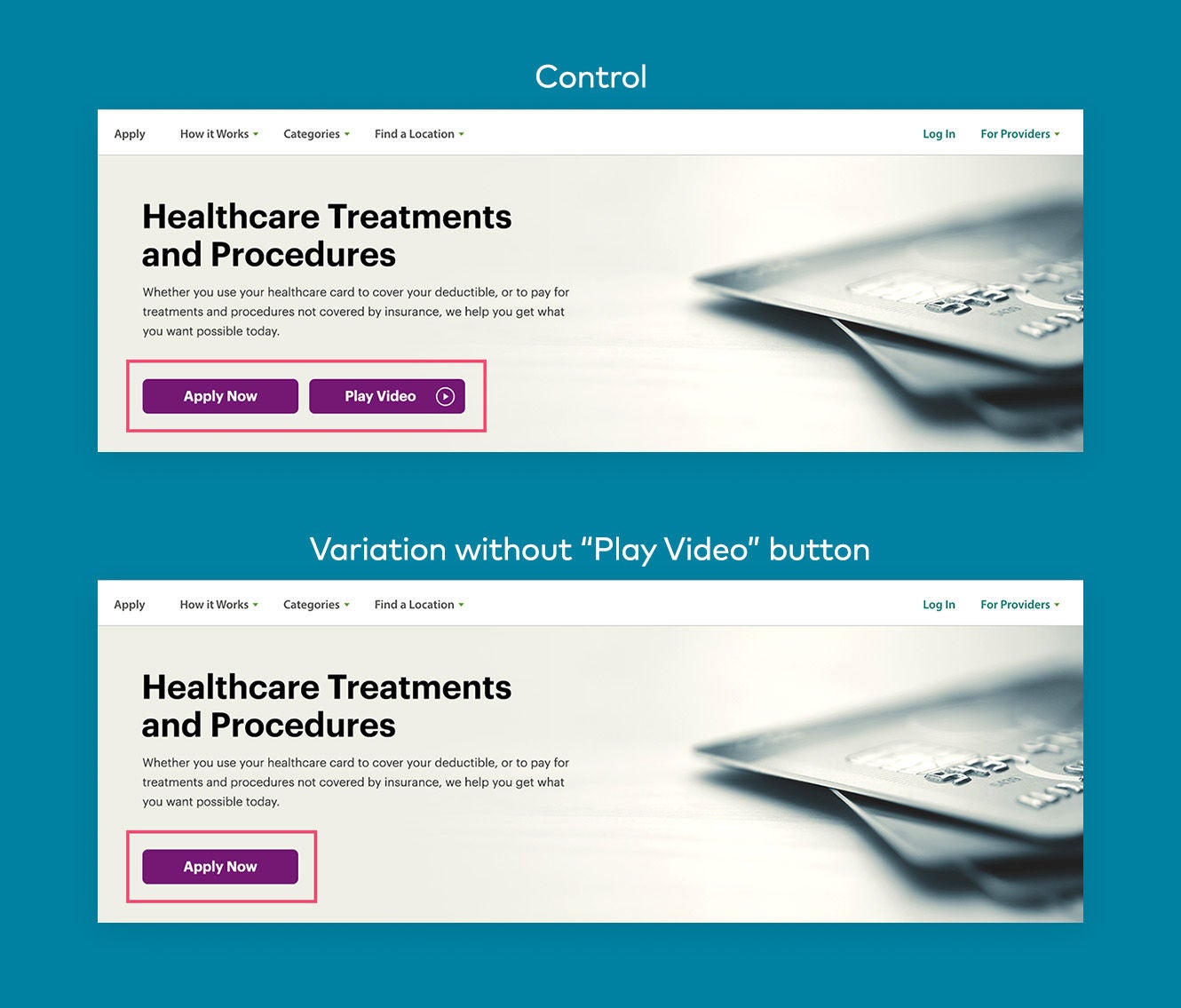

Eller hur är det om en återförsäljare som säljer både herr- och damprodukter bestämmer sig för att köra ett klassiskt A/B-test på sin hemsida för att identifiera den bäst presterande hero-bannervarianten, men eftersom 70 % av deras publik är kvinnor, presterar damvarianten bättre än mäns.

Detta test skulle tyda på att kvinnornas hjältefana skulle tillämpas på hela befolkningen, men det skulle säkerligen inte vara rätt beslut.

Enkelt uttryckt:

- Genomsnitt är ofta missvisande när de används för att jämföra olika användargrupper

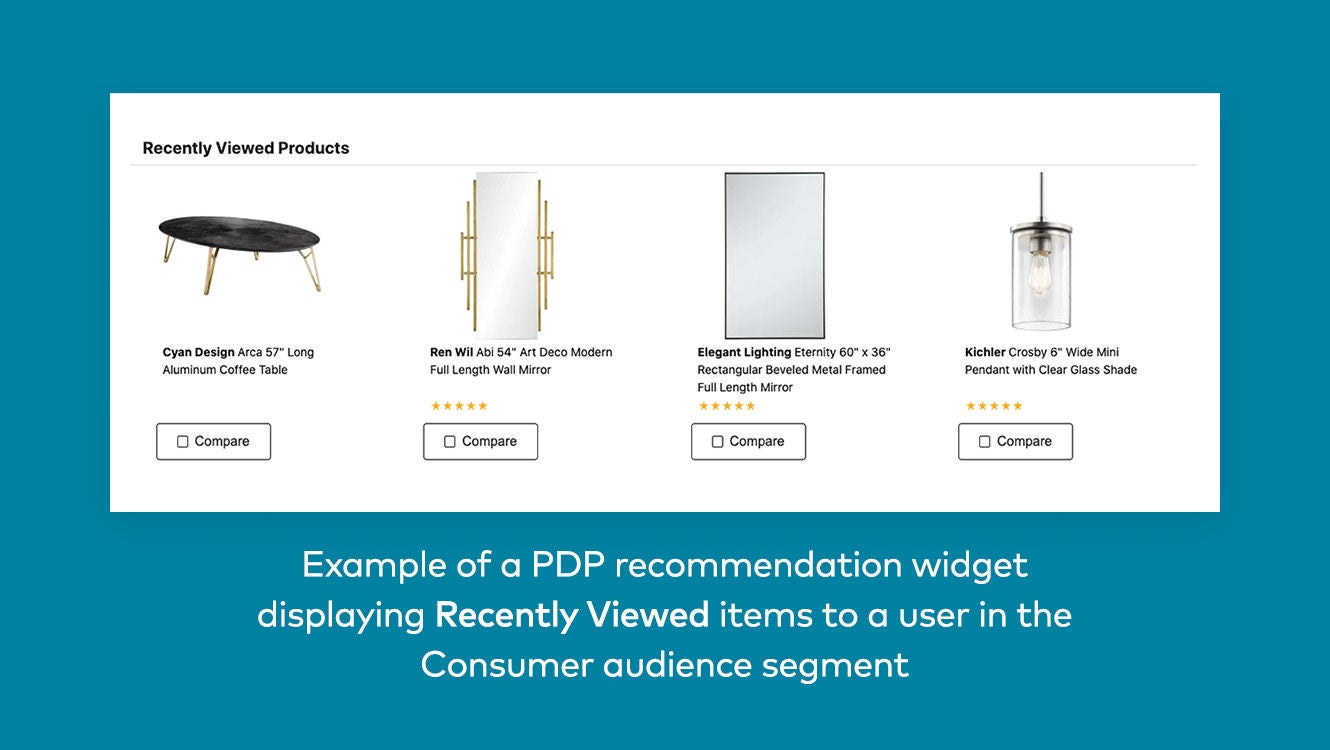

- De bäst presterande variationsändringarna för varje kundsegment och användare

- Resultaten kan också påverkas av kontextuella faktorer som geografi, väder och mer

Detta betyder naturligtvis inte att det inte finns en tid och plats för att utnyttja mer generaliserade resultat. Om du till exempel testar en ny webbplats- eller appdesign vore det klokt att sikta på ett enhetligt användargränssnitt som fungerar bäst i genomsnitt jämfört med dussintals, hundratals eller till och med tusentals UI-variationer för olika användare.

Men dagarna då vi troget hade en "vinnaren tar allt"-strategi för layout av en sida, budskap, innehåll, rekommendationer, erbjudanden och andra kreativa element är över – och det är okej eftersom det betyder att det inte längre kommer att finnas pengar kvar på bordet från missade personaliseringsmöjligheter i samband med att man inte levererar den bästa variationen till varje enskild användare.