La premisa de las pruebas A/B es simple:

Compare dos (o más) versiones diferentes de algo para ver cuál funciona mejor y luego implemente la ganadora para todos los usuarios para obtener la experiencia general más óptima.

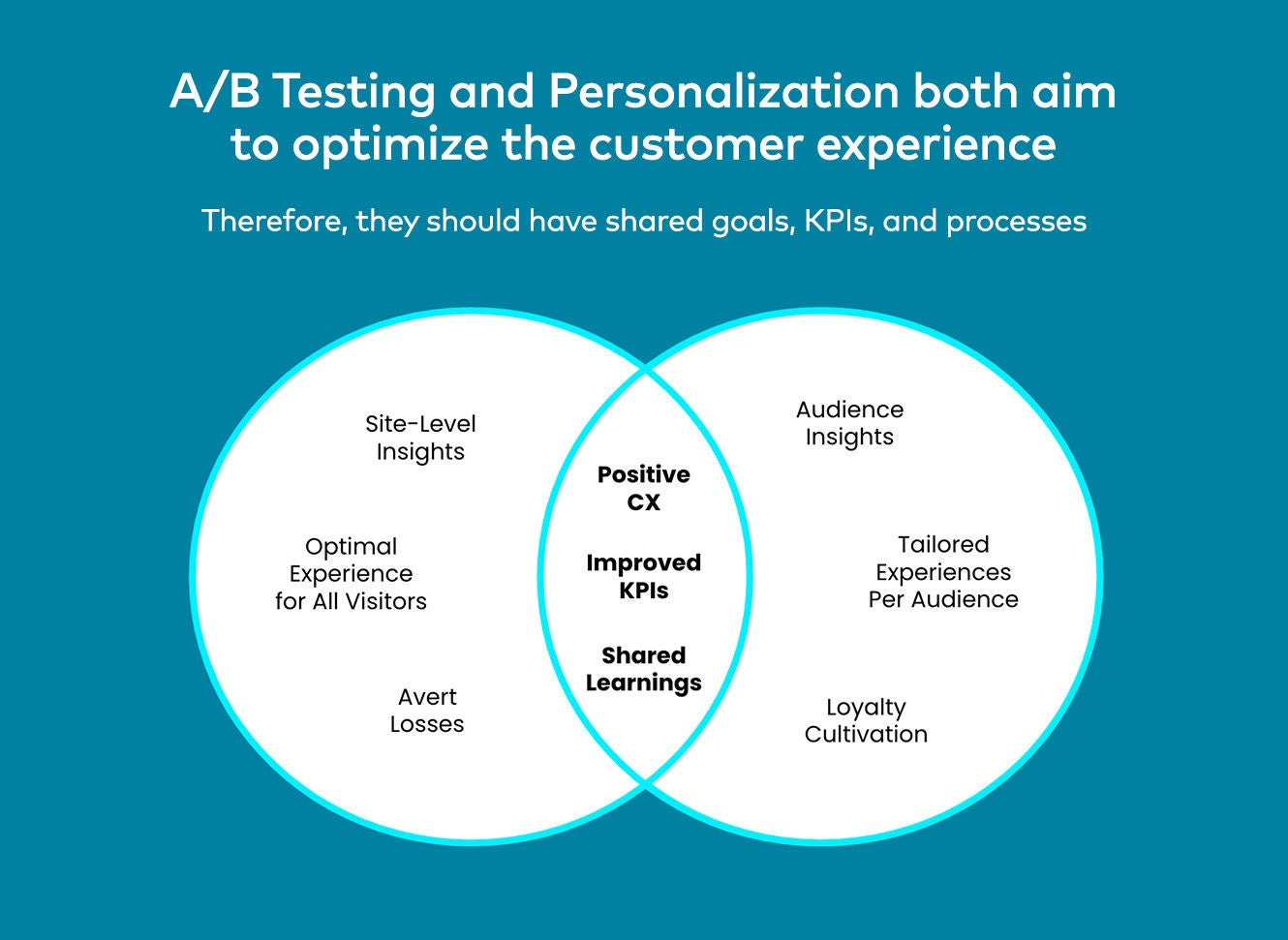

Por lo tanto, la práctica de las pruebas A / B y los equipos de CRO fue invertir significativamente en el lanzamiento de todo tipo de experimentos para mejorar diferentes áreas y experiencias en el sitio, la aplicación nativa, el email o cualquier otro canal digital y luego optimizarlos continuamente para impulsar un aumento incremental en las conversiones y KPI específicos a medida que pasa el tiempo.

Sin embargo, a menos que una compañía genere toneladas de tráfico y tenga un enorme entorno digital desde el cual experimentar, puede llegar un punto de rendimientos decrecientes donde el resultado de la experimentación (sin importar cuántas pruebas haya o cuán grande y sofisticado sea un experimento) alcanza un rendimiento máximo en términos de la inversión de estos equipos.

Esto tiene que ver en gran medida con el hecho de que el enfoque tradicional de las pruebas A/B ofrece una visión binaria de las preferencias de los visitantes y, a menudo, no logra capturar la gama completa de factores y comportamientos que definen quiénes son como individuos.

Además, las pruebas A/B generan resultados generalizados basados en las preferencias mayoritarias de un segmento. Y si bien una marca puede descubrir que una experiencia particular genera más ingresos en promedio, implementarla para todos los usuarios sería un flaco favor a una parte importante de los consumidores con preferencias diferentes.

Permítanme ilustrarlo con algunos ejemplos:

Si mi patrimonio neto y el de Warren Buffett fueran de 117.300 millones de dólares de media, ¿tendría sentido recomendarnos los mismos productos?

Probablemente no.

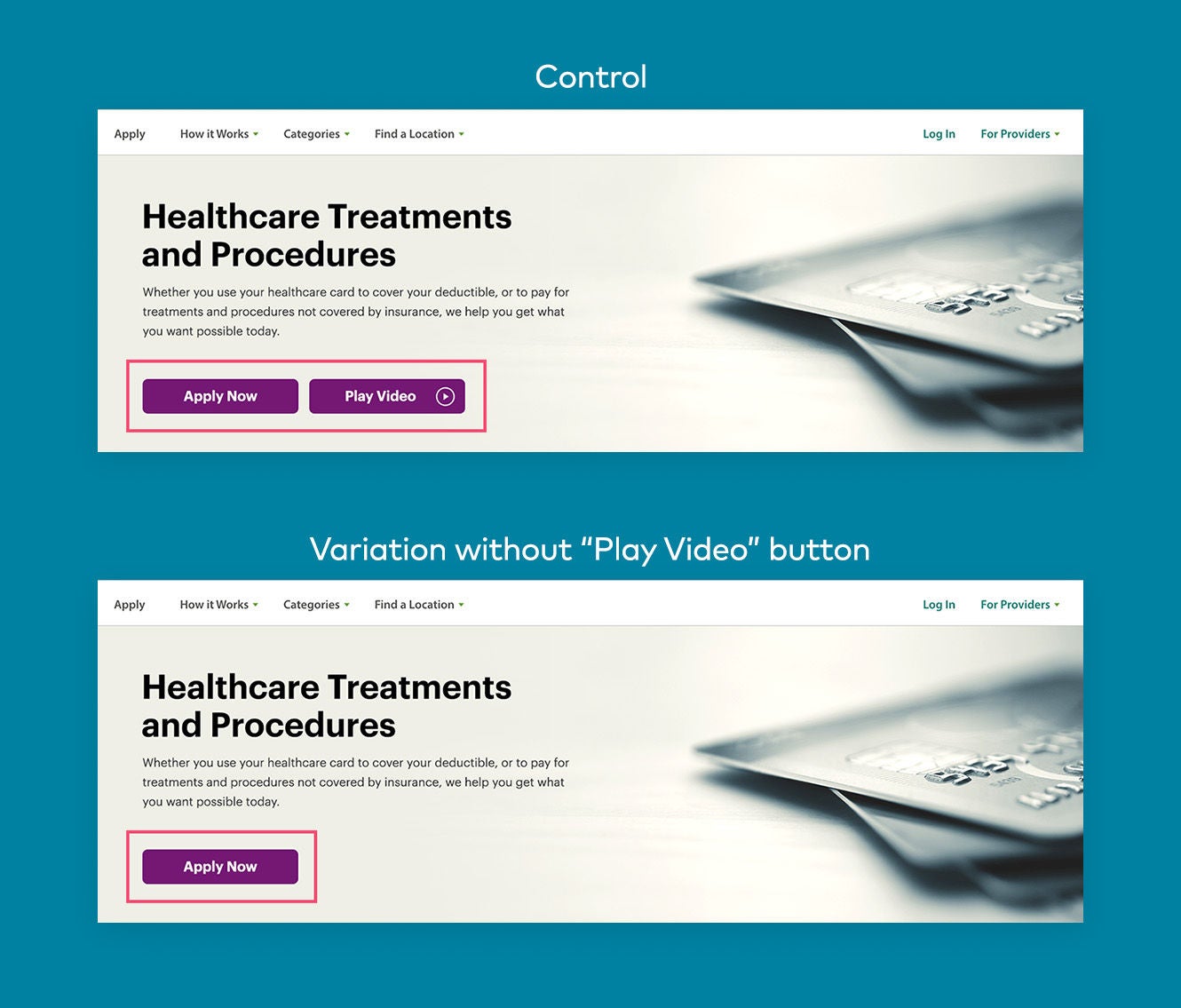

¿O qué tal si un minorista que ofrece productos tanto para hombres como para mujeres decide realizar una prueba A/B tradicional en su página de inicio para identificar la variación de banner principal con mejor rendimiento, pero dado que el 70% de su audiencia son mujeres, la variación para mujeres supera a la de hombres?

Esta prueba sugeriría que el estandarte de héroe femenino se aplique a toda la población, pero seguramente no sería la decisión correcta.

En pocas palabras:

- Los promedios a menudo son engañosos cuando se usan para comparar diferentes grupos de usuarios

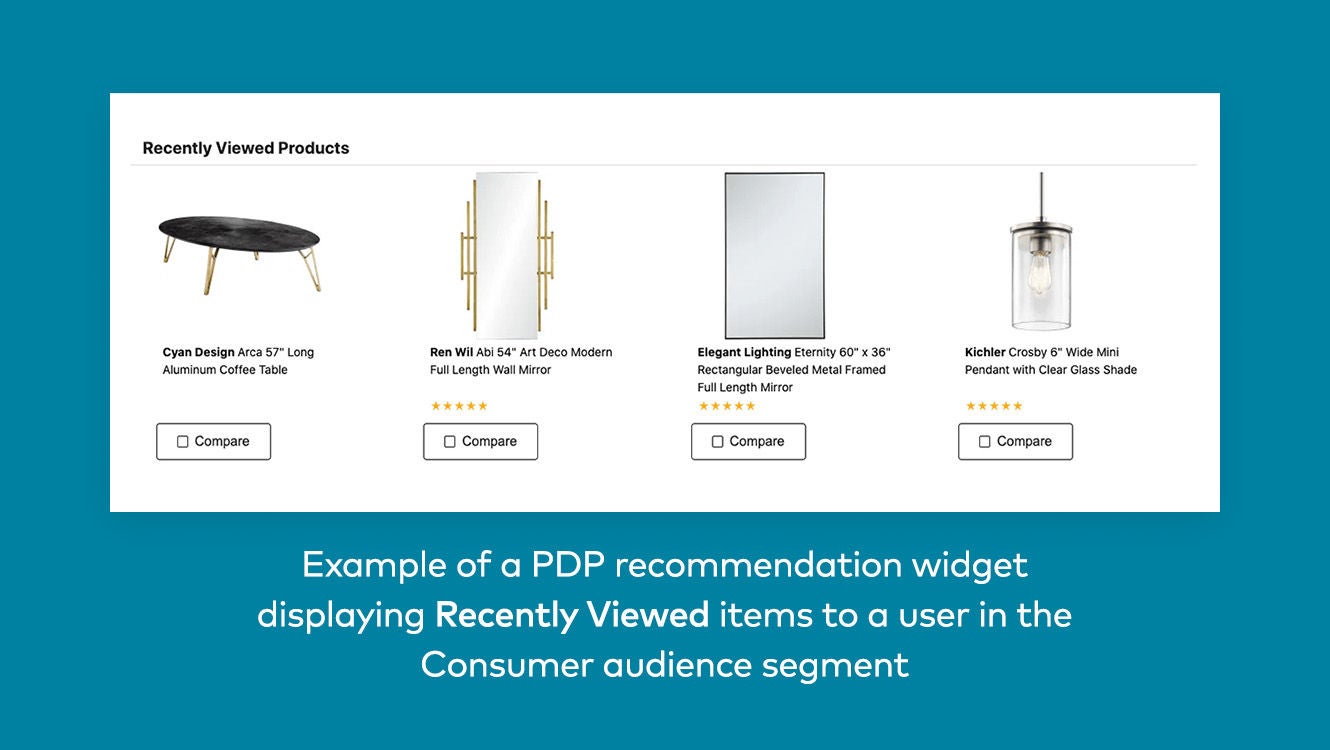

- La variación de mejor rendimiento cambia para cada segmento de clientes y usuario

- Los resultados también pueden ver influenciados por factores contextuales como la ubicación geográfica, el clima y más

Esto no quiere decir, por supuesto, que no haya un momento y un lugar para aprovechar resultados más generalizados. Por ejemplo, si estuvieras probando un nuevo diseño de sitio web o aplicación, tendría sentido apuntar a una interfaz de usuario consistente que funcionara mejor en promedio frente a docenas, cientos o incluso miles de variaciones de interfaz de usuario para diferentes usuarios.

Sin embargo, los días de adoptar fielmente un enfoque de "el ganador se lo lleva todo" para el diseño de una página, mensajes, contenido, recomendaciones, ofertas y otros elementos creativos terminaron, y eso está bien porque significa que ya no se dejará dinero sobre la mesa por las oportunidades de personalización perdidas asociadas con no ofrecer la mejor variación a cada usuario individual.